▲Google語音研究員Dimitri Kanevsky使用AI語音辨識軟體(Google提供)

匯流新聞網記者鄭仲甫/台北報導

日常生活中,我們透過各種方式溝通,肢體動作、書寫或是最稀鬆平常的口語等,對絕大多數的人而言,動動嘴巴就能溝通是理所當然,但社會上有一群人卻難以做到這理所當然,對數百萬罹患中風、肌萎縮性脊髓側索硬化症 (ALS, Amyotrophic Lateral Sclerosis)、多發性硬化、創傷性腦損傷和帕金森氏症等因神經系統疾病而產生語言障礙的人士來說,難以表達,才是「理所當然」。

為了協助患者克服語言障礙,Google AI for Social Good的Project Euphonia 團隊和非營利組織ALS-TDI (美國 ALS 研究機構)與ALS Residence Initiative (ALS 住宅計劃)合作,嘗試透過AI提高電腦理解各種說話型態的能力,來幫助ALS患者溝通。

ALS是一種神經退化疾病,會導致患者失去聲音與其他隨意肌的功能;據悉,Project Euphonia 團隊藉由錄下ALS 患者的聲音,並試著瞭解 ALS 患者的溝通需求,強化AI模型資料庫,便讓手機和電腦更準確地辨識與轉錄這類患者說出的語句。

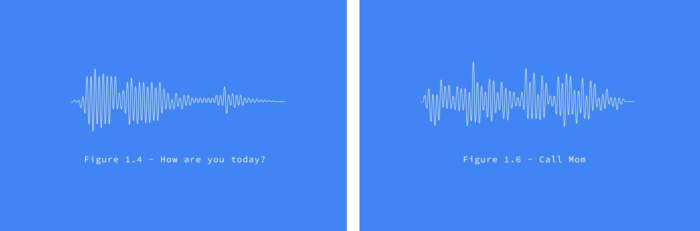

▲Google將受試者讀出的語句範例轉成聲譜圖(Google提供)

Google AI產品經理Julie Cattiau解釋,為了達到目標,團隊首先將錄下的聲音透過Google軟體轉化成聲譜圖,以更視覺化的圖像方式來呈現聲音。接著電腦會用這些經過正確轉錄的聲譜圖「訓練」我們的系統,以便更準確地辨識這類非典型的語音。

除了語音辨識能力,團隊也會訓練可偵測聲音或手勢的個人化模型,未來AI可以針對使用者行為做出相關行動,例如對Google Home下達語音指令或傳送簡訊。這類模型對於患有嚴重殘疾且已無法說話的人士來說會特別有幫助。

Julie表示,目前的AI模型設計是針對典型 ALS 相關障礙的英語人士為目標對象,但相信未來這項研究可被應用到更大範圍的族群與不同的語言障礙上。

此外,由於AI資料庫的建立需要龐大的樣本,Google也提供線上表單,讓來自世界各地的患者,申請幫忙錄製更多樣本,加速AI模型的發展,也歡迎大眾擔任合作專案非營利組織志工,為語言障礙患者發聲。

新聞照來源:Google

更多匯流新聞網報導:

Google新功能連環發!主動追蹤網購物流、相簿內聊天室上線

【匯流筆陣】

CNEWS歡迎各界投書,來稿請寄至[email protected],並請附上真實姓名、聯絡方式與職業身份簡介。

CNEWS匯流新聞網:https://cnews.com.tw

【文章轉載請註明出處】

延伸閱讀

【CNEWS】 「畫面重現」誰習慣性咆哮?鍾佳濱提裝「噪音檢測設備」 翁曉玲喊支持最好「AI抓臉」

- 2024-12-20

- 王 聿瀠

桃竹竹苗四縣市庇護工場聯合行銷 打造友善就業環境

- 2024-12-19

- 李 映萱

【有影】藍牙音訊策略佈局有成 達發科技高階AI物聯網事業營收過50%

- 2024-12-18

- 胡 照鑫